看清星星的脸

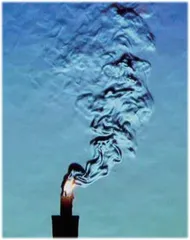

作者: 田浩宇一闪一闪亮晶晶,满天都是小星星。你可曾想过,为什么星星会眨眼睛?地球的大气不仅不均匀,还不稳定,同一时刻不同位置、不同时刻相同位置大气的湿度、温度、密度等不尽相同,这便会导致光的折射。因此,到达地面的星光并非是走直线过来的,而是经历了九曲十八弯。假设大气均匀,眼睛或望远镜收集到的天体上某一点发出的光线最后也应该汇聚为一个点,但现实情况是,每条光线受到不均匀的大气干扰的程度不同,光线无法汇聚为一点,图像因此变得模糊,再加上大气总在抖动,模糊的星星便会一直“闪烁”。

上天看星星不划算

既然大气的不均匀和不稳定会削弱望远镜的成像质量,那么怎样才能消除这种负面影响,从而看到清晰的图像呢?最直接的办法是把望远镜架在太空中,不经过地球表面的大气。

1946年,天文学家莱曼·斯皮策提出在太空中建造望远镜进行天文观测的设想。1990 年,哈勃太空望远镜成功上天,成为首台在太空中进行天文观测的望远镜,并拍到了很多酷炫的太空照片,运行至今。然而,太空望远镜毕竟太过“高大上”,又能造几台太空望远镜来看清星星呢?

在地上就能擦亮眼

为了克服大气的干扰,在地面上看清星星的真容,20 世纪50 年代,天文学家霍勒斯·巴布科克提出了一个方法:用受“波前传感器”驱动的光学元件,补偿大气扰动对望远镜成像的影响。这句话大多数人乍听可能一头雾水。首先,波前传感器是个什么东西?

波前,有时也被称为波面,描述的是一个和光线传播方向垂直的曲面。理想平行光的波前是一个平面,点光源的波前是一个球面。

由于大气干扰,光线穿过大气的时候,其波前会产生畸变。因为有了波前畸变,所以图像就变得模糊,因为波前畸变在不停地发生变化,所以图像就模糊且抖动。

既然波前畸变是图像模糊和抖动的直接原因,那何不用一个元件产生反向的波前畸变,正好和大气引起的畸变相互抵消呢?这样大气的干扰不就被消除掉了吗?但是怎么知道应该抵消多少呢?万一抵消过头了怎么办?这就需要先用一个仪器(即波前传感器)测量大气引起的波前畸变,再通过光学元件来准确地校正、抵消这个畸变,从而达到“正1 加负1 等于零”的效果。而且因为大气是在不停变化的,所以这个“测量+ 校正”的过程还需要不停地循环,以达到动态校正的效果。这就是自适应光学的理念。

“自适应光学”这个词虽然听着很厉害,但离我们并不遥远,因为我们每个人身上都有这么一套自适应光学系统,那就是我们的眼睛。人眼接收外界环境的光线,在视网膜成像,图像被送入大脑,大脑实时地对图像进行处理、分析,判断图像的清晰度,然后控制人眼的睫状肌收缩,调整晶状体变形,最后在视网膜呈现清晰的图像。这是典型的测量、控制、校正过程,只不过这一切发生得太快、太自然,所以你没有感觉到而已。

自适应光学的用武之地

自适应光学的思想非常先进,它突破了传统光学的局限,把测量、控制、校正的思想引入了光学领域,而且要求系统能够实时动态地消除大气的干扰。这哪里是单纯的光学领域,机械、电子、图像控制什么都有,按照目前时髦的说法,这属于交叉领域,而且是深度交叉。

话说回来,自适应光学的想法听起来很好,但是实现起来却很难。为了满足实时测量、控制、校正的要求,自适应光学系统的关键器件需要达到很高的性能要求。想想看,晶体管是1947 年诞生的,第一台晶体管计算机直至1953 年才被研制出来,大规模集成电路到1953 年才出现。在这个自适应光学的想法被提出的20 世纪50 年代,想要完成实时高速的波前测量、控制、校正这一系列操作,谈何容易。因此,自适应光学最开始主要用在激光武器、天文观测等非常前沿的领域,不是一般人唾手可得的。

后来,随着半导体光电子行业的迅猛发展,各种高性能、相对廉价的器件出现了,这一技术才慢慢进入大众的视野,开始被更多的人接触、了解、接受。尤其近年来,很多应用领域不再满足于传统光学系统的性能局限,开始追求更快、更高、更强,自适应光学开始在这些领域大显身手。

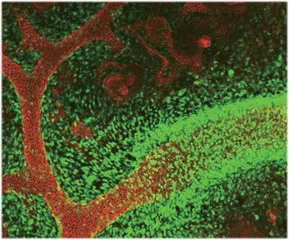

自荧光蛋白发现以来,用荧光标记技术对神经细胞的钙离子进行动态光学显微成像是神经领域科学家研究大脑功能最主要和最直观的手段之一。然而,目前的显微成像技术面临的一大难题是哺乳动物脑组织固有的光散射特征:在实施大深度生物组织成像时,样品的不均一性会引起光学像差,深度增加,像差也随之增加,从而难以将激光完全聚焦于深层组织中的精细结构上来获得高解析度的图像。最近几年,有科学家尝试将自适应光学技术引入深度脑部成像过程,开创了一项飞跃性的非侵入式活体组织显微成像技术。