复杂对抗场景下的对空目标混合智能抗干扰研究

作者: 张良 李少毅 杨曦 田晓倩

摘 要:目标识别与抗干扰技术已经成为决定精确制导武器性能优劣的关键技术。 本文针对复杂对抗场景下红外空空导弹作战特点,分析了其目标识别与抗干扰发展需求,提出了融合传统算法与深度学习的混合智能抗干扰算法。 该算法充分利用传统算法在确定场景下的高可靠性优势与深度学习算法在复杂场景下的高维特征提取能力,最大化挖掘了导弹探测的场景信息,对于提高系统抗干扰能力具有重要意义。 在此基础上,构造了算法测试训练的空战数据集,覆盖了典型的空战作战场景。 实验结果表明,相同特征融合条件下,典型场景混合智能抗干扰算法的全程抗干扰概率达到了71.56%,比传统算法提高了15.77%,验证了算法的有效性。

关键词:红外空空导弹;智能抗干扰;空战数据集;特征提取;目标识别;深度学习

中图分类号:TJ760.2; V271.4 文献标识码: A 文章编号:1673-5048(2022)01-0022-07[SQ0]

0 引 言

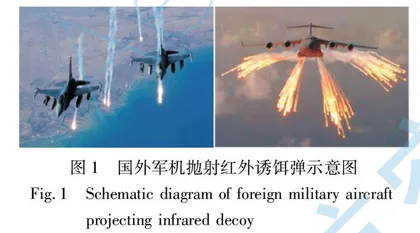

现代战争中,没有人工干扰的净空作战条件已经不复存在,新型干扰不断出现、战场环境瞬息万变,使传统基于人工定义特征和逻辑的算法难以应对。 近年来在导弹型号研制和部队训练中频繁暴露出的问题表明,空空导弹的抗干扰能力已经成为能否达成其作战意图的首要性能。 图1所示为国外军机抛射红外诱饵弹示意图。

导引头抗自然背景和人工诱饵干扰能力的提升主要依赖于目标检测识别算法的性能[1]。 目前,导弹抗干扰方法主要通过强化空中目标和诱饵红外特性认识,充分挖掘热成像视觉特征,基于特征相似性匹配实现自动目标识别。 传统基于逻辑规则的算法由于阈值设置缺乏灵活性、规则表达存在局限性,难以应对瞬息万变的战场环境[2-3]。 人工智能技术的推理、学习等能力恰恰能丰富和完善抗干扰过程中的目标与场景定义、特征提取等功能,不仅能提高对目标的检测识别能力,而且能通过对环境及攻防对抗态势的融合分析生成最佳博弈策略,对于提高导弹在复杂环境下的作战能力具有重要意义。

自2006年以来,深度学习方面的文献层出不穷[4-6]。 深度学习技术带来的进步主要体现在能够从数据中学习提取出目标特征,这些特征无论从数量上,还是维度或复杂度上,都远超设计人员手工设计的特征。 但深度学习存在不可解释的特点,这对于复杂对抗、真实数据缺乏的空战场景应用带来了较大的不确定性[7-8]。

针对该问题,本文充分利用传统算法在确定场景下的高可靠性优势与深度学习算法在复杂场景下的高维特征提取能力,提出一种复杂对抗场景下的对空目标混合智能抗干扰算法,最大化挖掘导引头图像蕴含信息,极大提高红外空空导弹在复杂场景下的感知对抗能力。

1 混合智能抗干扰算法

混合智能抗干扰算法是在传统抗干扰算法框架基础上,将深度学习算法和传统特征融合算法在弹道阶段、特征维度、功能层面结合的一种智能算法,既保证算法的高准确率,同时一定程度上提升了算法的可解释性。

传统多特征融合算法以统计模式识别算法中的最小距离分类法为核心,使用输入特征矢量与特征空间中模板的点之间的距离作为分类的准则。 利用最高灰度、灰度均值、能量、长宽比、周长、面积等特征作为分类的依据。

设m类中有m个参考向量R1,R2,…,Rm,分别属于ω1,ω2,…,ωm。 若输入特征矢量X与参考向量Ri的距离最小,则认为X∈ωi。 X与Ri的距离为

Di(X, Ri)=X-Ri=(X-Ri)T(X-Ri)(1)

式中:当Di(X, Ri)<Dj(X, Rj) (j=1, 2, …, m, j≠i)时,X∈ωi。

目前,空空导弹红外成像导引头的目标探测识别与抗干扰策略主要是借助专家知识进行设计[9-11],其典型流程是:(1)图像预处理,提升信杂比;(2)分割,区分前景与背景;(3)提取前景区块的特征,通常包括灰度、面积、周长等;(4)根据特征确定目标。 每个步骤都有多种实现方法,根据多个条件判断在不同方法之间进行切换,实现多种目标检测与抗干扰措施之间有规律的转换。 虽然对特定类型的场景具有较好的检测识别和抗干扰性能,但很难灵活地适应实战环境下瞬息万变的战场态势。

如图2所示,不同于传统算法设计的核心思想是将人的认识转化为导弹能够执行的逻辑与规则集合,融合深度学习的混合智能抗干扰算法在此基础上能够自动从数据中学习难以直接利用规则描述的复杂特征,大大扩展可利用的信息维度。

混合智能抗干扰模型原理为

f(Xi)=h{T[Xi, R1i(Xi)], L[Xi, R2i(Xi)],

si(Xi)}(2)

式中:Xi为当前图像;f(Xi)为当前算法的输出结果;R1i(Xi)为传统算法特征值;T[Xi, R1i(Xi)]为传统算法的输出结果;L[Xi, R2i(Xi)]为深度学习算法的输出结果;R2i(Xi)为深度学习算法特征值; si(Xi)为当前场景分类的结果。

根据场景分类si(Xi)的结果,可以将式(2)变为以下两种形式:

(1) 满足特征融合要求的形式:

f(Xi)=T[Xi, R1i(Xi)+R2i(Xi)](3)

将传统特征与深度学习特征融合,在传统多特征融合算法的框架下进行目标识别。

(2) 满足结果融合要求的形式:

f(Xi)=α·T[Xi, R1i(Xi)]+β·L[Xi, R2i(Xi)](4)

将传统特征与深度学习结果融合,其中α, β是根据si(Xi)结果变化的系数,且α+β=1。

1.1 深度学习算法模块设计

深度学习本质上是构建含有多隐层的神经网络,通过大规模数据进行训练,得到大量更具代表性的特征信息。 从而对样本进行分类和预测,提高分类和预测的精度。 这个过程是通过深度学习模型的手段达到特征学习的目的。 深度学习模型和传统浅层学习模型的区别在于:首先,深度学习模型结构含有更多的层次,包含隐层节点的层数通常在5层以上;其次,明确强调了特征学习对于深度模型的重要性,即通过逐层特征提取,将数据样本在原空间的特征变换到一个新的特征空间来表示初始数据,使得分类或预测更加容易实现。

一些人类事先根本没注意到的复杂特征,也能够被卷积神经网络提取出来。 利用卷积神经网络进行目标检测和识别,不仅大幅提高了图像识别的精度,同时也避免了需要消耗大量时间进行人工特征提取的工作,使得运算效率大大提升。

图3所示为当前主要的目标检测算法。 目前主流的基于深度学习的目标检测算法,大致可以分为两大类别:(1)Two-Stage目标检测算法。 这类检测算法将检测问题划分为两个阶段,第一个阶段产生候选区域(Region Proposals),包含目标大概的位置信息,第二阶段对候选区域进行分类和位置精修。 这类算法的典型代表[12-14]有R-CNN,Fast R-CNN, Faster R-CNN等。 (2)One-

Stage目标检测算法。 这类检测算法不需要Region Proposal阶段,可以通过一个Stage直接产生物体的类别概率和位置坐标值。 代表性的算法[15-16]有YOLO,SSD和CornerNet。

目标检测模型的性能指标是检测准确度和速度,其中准确度主要考虑物体的定位及分类精度。 一般情况下,Two-Stage算法在精度上有优势,而One-Stage算法在速度上有优势。 不过,随着研究的发展,两类算法都做了改进,均能在准确度以及速度上取得较好的结果。

由于弹载应用对算法实时性要求很高。 Two-Stage检测算法中,经典的检测方法生成候选区域都非常耗时,如R-CNN使用SS(Selective Search)方法生成检测框,在Nvidia Titan X上只有0.02 fps的检测速度。 即便宣称极大地提升了检测框生成速度的Faster R-CNN在同等条件下也只有7 fps的检测速度。 而One-Stage类中的代表算法SSD300,在同等硬件条件下,能够达到46 fps,且拥有和Faster R-CNN相当的检测精度。 因此,考虑对空目标探测识别的高实时性要求,本文采用单阶段检测算法开展算法设计。

本文的应用场合需要考虑弱小目标检测,选取一个弱小目标检测能力强的目标分类器是十分必要的,因此,选取了YOLOV3目标检测算法的尾部分类器[17]。 YOLOV3由华盛顿大学的Joseph Redmon和Ali Farhadi于2018年提出,旨在提升目标检测的检测效率,试图使目标检测达到实时检测的程度。 特别在经过改进后,YOLOV3能在提升目标检测效率的同时保持检测精度,是双赢的算法。

YOLOV3使用的是Darknet-53的网络结构(含有53个卷积层),其借鉴了残差网络的做法,在一些层之间设置了快捷链路(shortcut connections),从而加深了网络的深度,使网络提取特征的能力更进一步加强,如图4所示。

MobileNet是Google提出的一种轻量级网络,体积小,计算量少,适用于移动设备,MobileNetV2[18]在一代基础上提升了训练速度并有效解决了梯度弥散的问题。 虽然MobileNetV2的精度(74.9%)略低于Darknet-53,但由于弹上资源有限,Darknet-53等其他大型网络部署起来会有困难,权衡之下,选用MobileNetV2作为YOLOV3的特征提取器。 MobileNetV2网络结构如表1所示。

1.2 混合智能抗干扰算法设计

从特征级和决策级两个层面开展传统目标识别算法与深度学习算法的融合设计。 决策级:一方面,利用深度学习算法输出结果辅助传统算法进行执行路径选择;另一方面,根据场景对深度学习算法和传统算法的识别结果进行融合,在提高目标识别正确概率的同时保证跟踪点的稳定性。 特征级:通过深度学习算法得到场景所有对象的态势分布,将该分布态势信息矢量化表示形成特征信息后与传统算法成像特征进行融合。

1.2.1 场景分类

传统算法在可定义确定场景下能够取得较好的识别效果,且具有高可靠性的优势。 由于场景类别的判断本身具有一定的难度,而深度学习算法可以通过对场景中各对象类型的输出,综合得出场景类别[19-21],因此,将深度学习算法的场景分类结果输出给传统算法,传统算法根据场景类别选择规定好的执行路径,提高算法对于复杂场景的适应能力。

根据训练好的模型,识别该时刻场景所处的分类情况,进而选择更适合的参数或算法对图像进行处理,提升处理精度及效率。 如图5所示,通过场景分类算法得出目前所处的阶段及目标态势,选择目标态势最适用的算法处理目标信息。 如远距应选择小目标检测识别算法;目标若处于复杂机动条件下,应选择对应的复杂机动条件下的识别和跟踪方法,以确保处理不同场景所依赖的算法及参数处于最优状态。

1.2.2 特征融合

目标识别主要基于红外干扰与真实空中目标在红外成像上的差异性,充分提取并利用相关成像特征,构建目标模型并进行识别判定,抗干扰过程中存在目标特征连续性被破坏、干扰与目标特征相似带来的目标难以识别问题,而深度学习具有极强的特征表示能力,因此,可将卷积神经网络提取的深度特征与传统人工特征融合进行目标识别。

人工特征的提取主要依赖先验知识,通过对图像分割后的候选区域进行处理,最大程度找出能反映不同样本间差异的特征变量,通常以能反映能量强度、外形轮廓等的物理量为主。 本文所选的特征有长宽比、周长、面积、能量、灰度均值、熵、傅里叶描述子。

深度学习网络输出的特征图反映了像面的对象分布态势,将该分布态势信息矢量化表示形成特征信息后,可以与传统算法提取的像面成像特征融合,得到更加完整和全面的特征表示。 如发生目标被新的诱饵遮挡情况,利用深度学习输出的分布矢量特征,与传统算法的成像特征融合,完成当前时刻目标与干扰相对位置矢量的观测与估计。

图6所示为目标与干扰的深度特征图。 通过这些抽象程度不高的特征图可以看出,目标与干扰的特征提取较为准确,其主要轮廓特征可以清晰分辨,特征差别较为明显,特征描述较为准确。 不难推断,高维深度特征也具有此类特性。 所以,对于目标与干扰深度卷积特征,可以用目标分类识别的一项约束,与传统特征进行融合。