面向网络入侵检测的对抗攻击系统

作者: 潘宇恒 廖思贤 杨朝俊 李宗和 于婷婷 张瑞霞

摘要:该项目研究多种白盒攻击算法生成白盒对抗样本的效率,同时运用生成对抗网络(GAN) 技术来生成黑盒对抗样本,并且通过构建网络入侵检测模型包括误用检测和异常检测模型,来测试这些生成的对抗样本在面对多种不同入侵检测模型时的攻击的成功率,最终构建一个网络入侵检测系统的对抗样本生成器(包含白盒和黑盒对抗样本)。

关键词:对抗样本;网络入侵检测;生成对抗网络;机器学习

中图分类号:TP393 文献标识码:A

文章编号:1009-3044(2024)04-0100-03

1 背景

随着人工智能的兴起和发展,机器学习算法在各个领域的应用也随之增加。尽管机器学习算法推动了人工智能的发展,但我们需要关注其安全性问题。研究人员经常更加关注模型的性能,而忽视了模型的脆弱性和鲁棒性。事实上,一些研究人员发现,当输入样本被轻微扰动时,机器学习算法模型可能产生误判[1]。

网络入侵检测是通过分析攻击目标的特征来进行分类判定。然而基于机器学习的网络入侵检测分类模型存在对抗样本的问题,这为网络入侵提供了新的手段,意味着入侵检测系统可能无法察觉到这种攻击行为,从而暴露了入侵检测系统在对抗攻击方面的脆弱性。目前,研究人员更加关注网络空间安全领域基于机器学习的安全检测系统的检测性能问题,而忽略了机器学习算法自身脆弱性带来的安全隐患。此外,我国目前对于对抗样本生成研究主要集中在计算机视觉领域,而网络空间安全领域的对抗样本生成研究还处于起步阶段[2]。

2 系统的总体设计

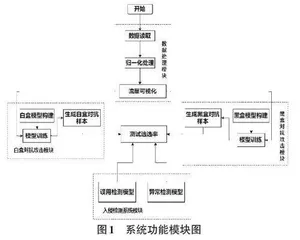

本系统中的生成对抗样本和进行对抗攻击测试流程如图1所示,首先输入网络入侵检测数据集来训练一个待攻击的白盒模型和之后用于测试恶意样本逃逸率的入侵检测模型,然后通过三种白盒对抗攻击算法(FGSM、DEEPFOOL、JSMA) 攻击训练好的白盒模型来生成白盒对抗样本,接下来利用大量的白盒对抗样本作为数据集去训练黑盒对抗模型来产生黑盒对抗样本,最后将白盒和黑盒对抗样本都输入训练好的入侵检测模型去测试这些经过处理的恶意样本的逃逸率。

3 系统详细设计与实现

3.1 白盒对抗攻击模块实现

FGSM(Fast Gradient Sign Method) 算法是一种基于梯度的对抗攻击方法,它利用模型的梯度信息来生成对抗样本。这个方法可以在目标模型上添加一组与原始图像中梯度方向相反的扰动,使模型产生误分类或误判。相较其他对抗攻击方法,FGSM具有生成速度快、便于实现等优点,因此成为对抗攻击领域中的重要方法之一。

JSMA(Jacobian-Based Saliency Map Attack) 白盒对抗攻击算法是一种基于梯度的对抗攻击算法,它通过计算输入图像的“显著性图”,并选择对模型最敏感的像素进行扰动来生成对抗样本。“显著性图”可以通过对原图进行梯度计算得到。该算法产生的对抗样本通常会在目标分类器上造成大的扰动,且不会改变图像原有的类别信息。

白盒抗攻击算法DeepFool[3]是一种针对神经网络分类器的快速线性化对抗攻击算法,其主要思想是通过线性化神经网络的判别界面来找到最小扰动,从而欺骗网络。DeepFool 算法是一种针对多类别分类问题的有效对抗攻击方法。与其他算法相比,它的功效更强,且计算速度更快。

在具体实现中,该模块首先输入网络入侵检测数据集来训练一个待攻击的白盒模型和之后用于测试恶意样本逃逸率的入侵检测模型,然后通过三种白盒对抗攻击算法(FGSM、DEEPFOOL、JSMA) 攻击训练好的白盒模型来生成白盒对抗样本,接下来利用大量的白盒对抗样本作为数据集去训练黑盒对抗模型来产生黑盒对抗样本,最后将白盒和黑盒对抗样本都输入训练好的入侵检测模型去测试这些经过处理的恶意样本的逃逸率。该功能工作流程如图2所示。

3.2 黑盒对抗攻击模块实现

2018年,Xiao等人提出了一种基于生成对抗网络(GAN) 的对抗样本生成方法,名为GAN-based Adver⁃sarial Training(GAT) [4]。GAT方法通过训练一个生成器网络和一个判别器网络,形成一种博弈的过程,用来生成具有强攻击性的对抗样本。在该方法中,生成器网络用于生成对抗样本,而判别器网络则用于判断真实样本和生成的对抗样本。生成器通过迭代生成对抗样本来降低判别器的识别率,从而使生成的对抗样本更接近于真实样本。相比其他对抗样本生成方法,GAT方法具有生成对抗样本效果更好的特点。它能够有效改善模型在对抗样本攻击下的性能,提升神经网络模型的鲁棒性和安全性。我们的黑盒模块正是借用了该思想进行黑盒攻击生成对抗样本。

具体实现中,我们设计的黑盒模块是用于将生成好的大量白盒对抗样本作为输入,来训练三种构建好的基于生成对抗网络(GAN) 技术的黑盒对抗样本生成模型,包括GAN、LSGAN、WGAN-GP模型,最终通过训练好的黑盒模型来生成黑盒对抗样本。该模块流程图如图3所示。

3.3 入侵检测系统模块实现

基于K-最近邻(KNN) 算法[5]的网络入侵检测技术使用已知攻击的数据样本和正常流量数据样本训练一个分类器,从而检测测试流量中的异常行为。该方法主要利用KNN算法,通过计算测试样本与已知类别的样本之间的距离,将其分类为正常流量或攻击流量。在模型训练过程中,可以使用特征选择和预处理技术来提高模型性能,并一次检测多个攻击类型。该论文的贡献是通过KNN算法将分类器和网络流量数据进行有效分类,以有效检测和分离入侵攻击。此外,KNN算法的简单性和易于实现性也为该算法的广泛应用提供了便利性。

基于深度自编码高斯混合模型(DAGMM) 算法[6]的异常检测技术可以在无须标记的数据集中进行入侵检测。DAGMM使用深度自编码神经网络来将原始数据编码成低维空间,利用高斯混合模型(GMM) 来学习数据在低维空间中的分布。然后,利用模型估算输入数据点的概率密度和重构错误,将其用作异常检测的条件。DAGMM算法可以自动学习数据的高级特征,并将其映射到低维空间,从而提高检测性能。此外,DAGMM还使用了降噪自编码器来处理输入数据的异常值,旨在消除误差。

在具体实现中,该模块首先要为白盒对抗攻击算法构建一个待攻击的白盒模型,这里选择使用DNN神经网络技术来构建该模型,并且构建的模型也用于测试对抗攻击的成功率。同时,为了研究基于主模型生成的对抗样本对于其他入侵检测模型的可迁移性,按照两种不同的检测方法构建以KNN网络设计的误用入侵检测模型和以DAGMM网络设计的异常入侵检测模型,这两个入侵检测模型用于对抗攻击逃逸率的测试。该模块流程图如图4所示。

4 系统测试

白盒对抗样本生成测试分别对三种白盒攻击算法——FGSM、JSMA、DEEPFOOL 生成对抗样本的个数进行10次统计,求其平均值,测试使用的每种算法所生成的对抗样本个数均为10000个,白盒对抗样本的逃逸率如表1所示。

黑盒对抗样本生成测试中,我们构建三种入侵检测系统的逃逸率。每个模型我们一共训练300轮,并抽取其中第0, 5, 10, 20, 40, 60, 80, 100, 150, 250轮生成的图片,每次抽取25张图片,每一行代表一个抽取轮次。模型GAN的生成器生成图片的过程图如图5 所示。

下面,我们分别列出面对构建的三种入侵检测系统的逃逸率,这三种黑盒模型所生成的对抗样本的逃逸率,测试使用的每种模型所生成的对抗样本个数均为100个,三种模型的逃逸率如表2所示。

5 结束语

本研究面向网络入侵检测的对抗攻击,即怎样生成网络入侵对抗样本使其逃逸网络入侵检测系统的检测。系统将对抗样本技术应用于网络入侵检测领域,同时该系统还引入生成对抗网络(GAN)技术来生成黑盒对抗样本,引入的GAN技术填补了目前对抗攻击无法作用于黑盒环境下的缺点,给予对抗样本技术一个新的思路。

参考文献:

[1] SZEGEDY C, ZAREMBA W, SUTSKEVER I, et al. Intriguing properties of neural networks[EB/OL].2013:arXiv:1312.6199.http://arxiv.org/abs/1312.6199.pdf

[2] 段广晗,马春光,宋蕾,等.深度学习中对抗样本的构造及防御研究[J].网络与信息安全学报,2020(2):1-11.

[3] MOOSAVI-DEZFOOLI S M,FAWZI A,FROSSARD P.Deep⁃Fool:a simple and accurate method to fool deep neural networks [C]//2016 IEEE Conference on Computer Vision and Pattern Recognition(CVPR). Las Vegas, NV, USA. IEEE, 2016: 2574-2582.

[4] Xiao C, Li B, Zhu J Y, et al. Generating adversarial examples with adversarial networks[C]//Proceedings of the 27th Interna⁃tional Joint Conference on Artificial Intelligence,2018:3905-3911.

[5] 吴晟懿.基于KNN算法的网络入侵检测技术开发[J].信息与电脑(理论版),2023,35(5):67-69.

[6] ZONG B, SONG Q, MIN M R, ET AL.Deep autoencoding gauss⁃ian mixture model for unsupervised anomaly detection[C]//Inter⁃national conference on learning representations,2018.

【通联编辑:代影】