结合词典释义基于BERT的汉语词义消歧

作者: 唐忠 李勇

关键词:词义消歧;BERT;消歧特征;词典释义;句法关系

中图分类号:TP391 文献标识码:A

文章编号:1009-3044(2024)21-0015-03

0 引言

词义消歧(Word Sense Disambiguation)是自然语言处理中的一项重要任务,旨在从预定义的语义清单中识别最合适的含义,以明确上下文中单词的语义[1]。词义是指在特定语言环境中词汇所表达的具体语言现象[2]。然而,无论是中文还是英文等其他西方语言,一词多义现象普遍存在。例如,“火箭”这个多义词既可指载人或无人航天任务所使用的发射载具,也可指美国职业篮球联赛中的一支球队。这种现象导致计算机难以准确处理多义词。由于汉语语言的独特性,它比英文更为复杂,因此面临更大的挑战,同时也带来了新的机遇。

词义消歧任务最初源于机器翻译领域。随着相关词典和语料库的逐步建设,词义消歧逐渐成为自然语言处理基础研究的重要组成部分。它的效果直接影响机器翻译[3]、信息检索[4]、文本分类[5]等应用的质量。此外,词义消歧的发展还能进一步推动句法分析、语法分析和语境分析的进步。因此,词义消歧具有重要的理论价值和实践意义。

1 相关工作

目前词义消歧的方法主要分为有监督方法、无监督方法和基于知识的方法。有监督方法通过在带有语义标签的数据集上进行训练,然后来判断新实例的正确词义。虽然说有监督方法可以达到最佳的消歧效果,但是由于标注语料库的限制,监督方法很难应用到大规模的词义消歧任务中。而无监督方法不需要带标注的语料,主要通过聚类的思想进行消歧,但是效果往往达不到最好。基于知识的方法都需要依赖外部知识库和词典资源,根据歧义词所在的上下文语境当中进行判断。

Lesk[6]算法是最早的消歧算法之一,它是一种基于字典的方法,通过计算待消歧词在字典中各语义的定义与语境重叠词的个数来选择正确的语义。模型IMS[7]使用SVM算法来在上下文语境中消除单词的歧义。该模型首次将待消歧词、周围词语的词性特征和上下文语境融合进模型中,取得了良好的消歧效果,也验证了词义消歧模型是非常依赖知识的。杨陟卓在传统的网络模型中引入了词语距离信息,提出了基于词语距离的网络图词义消歧方法[8]。罗俊丽[9]提出了一种基于语义关系图的词义消歧方法,针对传统方法无法对短小的用户查询词进行词义消歧的问题。利用改进的PageRank算法计算语义关系图中各词义节点的权重,并选择权重较大的词义作为消歧后的查询词的词义。陈浩[10]采用了一种无监督的方法,利用二阶上下文构建上下文向量,并采用k-means算法进行聚类。最后,通过计算相似性来排除词义,并且取得了很好的效果。

Kågebäck和Salomonsson提出了一种基于Bi-LSM的监督分类器,它在除最后一层外的所有单词类型之间共享参数。Raganato等人[12]将WSD任务转换为序列标记任务,从而为所有多义词建立统一的模型。罗干[13]将transformer网络融合LSTM网络来实现消歧,达到不错的效果。陈雅珍[14]基于柯林斯词典使用BERT考虑上下文特征和词性特征,充分验证了融合上下文和词性特征的有效性。张春祥等[15]基于K- means聚类与LSTM,首先对聚类特征进行数据转换,利用有标注语料迭代更新聚类中心,根据相似性计算对数据进行分类,提高了聚类的准确度。

有监督的模型虽然能够取得很好的消歧效果,但忽略了全局语义信息之间的联系,而且由于算法本身的复杂度,在面对大规模的训练数据时,时间和内存成本很高,如何降低开销成本仍有待商榷。根据之前的研究,发现知识对词义消歧有很大的帮助。本文提出基于BERT模型结合词典释义和句法知识的消歧方法,不过,在将数据输入到BERT模型之前,本文引用匹配的思想进行了部分消歧,能够极大提升模型的效率。本文提出的词义消歧丰富具有特点:引入词典词义,提取词典词条中的信息——词性、例句,首先通过匹配的思想进行排除部分义项;其次,通过句法分析得到待消歧词与句中其他成分的关系;最后,基于预训练语言模型BERT输入词典词义信息和句法信息确定最适当的义项。

2 词义消歧特征的抽取

词义是指在词典中对一个词语的定义,它反映了上下文语境中词与词之间的相互关系,融合了丰富的语言学知识。文本消歧特征一般需要在特定上下文语境中表示,主要体现为词单元之间的语言学信息。上下文的语义为确定歧义词汇的语义提供了一定的指导信息。本文针对歧义词汇,通过对待消歧句进行句法分析,得到与歧义词直接相关的成分和语义之间的依存关系,通过词典匹配进一步确定待消歧词的正确词义。对于未得到正确词义的例句,使用BERT预训练语言模型,通过引入特征进行消歧。

对于包含“使”歧义词的例句特征提取如下:例句:他使出全身力气冲了上去,一个“抱膝压腹”,将歹徒撂倒在地。

分词和词性标注结果:他/r 使出/v 全身/n 力气/n 冲/v 了/u 上去/v ,/w 一/m 个/q“ /w 抱/v 膝/Ng 压/v 腹/ Ng”/w ,/w 将/p 歹徒/n 撂倒/v 在地/u 。/w

结合《现代汉语字典》可以为消歧提供丰富的语义知识,字典中为每个字都提供释义、词性以及部分例句说明等信息。“使”在字典中的词条有:1) 动派遣;支使:使唤|使人去打听消息。2) 动使用:使拖拉机耕地|这支笔很好使|使上点肥料。3) 动让;叫;致使:办事使群众满意|加强质量管理,使产品合格率不断上升。4) 连假如。5) 奉使命办事的人:使节|大使|公使|特使|学使。

本文结合词典的消歧主要思想是进行匹配。消歧过程如下:首先进行词性对比。针对待消歧句中歧义词的词性,与词典词条中的词性对比,对于不符合的词性,可以直接排除该项词条。接着通过句法成分匹配,对待消歧句和词典中例句进行句法分析,匹配待消歧词的主语、宾语和状语等的属性与词条例句的相关属性。如图1是对例句进行句法分析的结果。待消歧词“使”的宾语“力气”,它们之间是一个受事关系,而对词典词条中的例句进行句法分析可以得到“使上点肥料”该例句中“使”和“肥料”也是受事关系。因此可以得到消歧结果。由此可见,待消歧词的词性及其在句中的句法关系可以很好地用于消歧。

3 基于语义知识的BERT模型

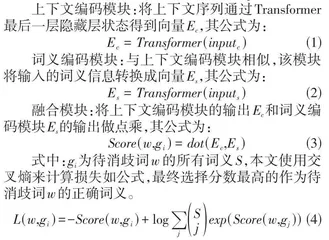

BERT(Bidirectional Encoder Representations from Transformers)是一种基于Transformers架构的预训练语言表示模型,由Google 研究人员于2018年提出[16]。BERT的主要创新在于利用了双向上下文信息,通过在大规模文本语料上进行无监督的预训练,学习出通用的语言表示。BERT模型中的其中一个预训练任务——掩码语言模型任务,即随机遮挡住句子中的单词,让模型来进行预测。这个任务类似于词义消歧任务在上下文语境中确定合适的义项。因此,本文在BERT模型的基础上,提出BERT-CY,将歧义词及上下文、提取出的特征(词性、依存关系)作为输入。图2 展示了模型的架构。

输入模块:上下文序列将经过分词后的上下文to⁃ ken序列拼接上待消歧词的真实词义,记为上下文序列inputc。词典词义集合将歧义词在词典词条中的释义和词性拼接起来,记为词典词义序列inputs。

4 实验分析

本文以SemEval-2007: Task#5的训练语料和测试语料作为训练数据和测试数据。本文基于HanLP系统平台进行实验。HanLP是由一系列模型与算法组成的工具包,具备分词、词性标注、关键词提取、自动摘要、依存句法分析、命名实体识别、短语提取、拼音转换、简繁转换等功能。本文对语料进行预处理,包括分词、词性标注和语义依存关系分析。本文使用了以下几种模型进行对比实验。

4.1 对比实验

1) MFS。MFS模型是词义消歧中最基础的模型之一。由于自然语言文本中的多义词的词义分布往往符合长尾效应,因此,该模型通常选择待消歧词的最常见词义作为消歧结果,忽略了待消歧词不常见的词义。

2) Random。Random模型是指在待消歧词的候选词义列表中随机选择一个词义作为消歧结果。

3) BEM。BEM是基于BERT的预训练模型,采用双编码器的结构。将待消歧词w 所在文本c 和w 对应的义项s1, s2, ..., sn分别用BERT编码,能够使模型更好地理解不同义项的含义。

通过使用上述模型和本文提出的模型在SemEval-2007 Task5数据集上进行对比实验,并根据数据集提供的自动评测方法宏平均精确率来对比不同词义消歧模型的消歧效果,结果如表1所示。

对比表中的消歧结果,本文提出的BERT-CY模型取得了最好的消歧效果,宏平均准确率达到了80.2%。可以发现,引入词典释义和句法关系能够提高消歧性能。

4.2 与ChatGPT 做对比实验

ChatGPT(Chat generative pre-trained transformer) 是OpenAI于2022年11月30日发布的聊天机器人程序。本文采用的ChatGPT是基于GPT-3.5架构,而其前一代基础模型GPT-3[17]的训练参数高达1750亿,训练数据更是高达45 TB。为了探究该模型在自然语言处理中基础任务的表现,本文用其进行简单的测试并对比本文的模型。在测试中,为了让ChatGPT更好地理解词义消歧任务,与本文进行同种实验,在测试时将词典词条中的义项一并输入给ChatGPT。由于账号限制,本小节仅使用了部分测试集进行简单的测试对比,结果如表2所示。

在测试中,ChatGPT有时并不会按照给定的词典词条中的词义义项,而是自己生成一个词义,导致测试结果有所不同。不过也可以看出ChatGPT模型能力的强大,这得益于其巨大的训练数据量和先进的训练方法。目前,ChatGPT又有所发展,训练的参数也越来越多,在此基础上又使用了海量的数据来进行训练,使得其表现更加优秀。

5 结束语

本文将词典中语义信息挖掘出来加入消歧模型中,从词典中提取到了词性、例句信息,并结合上下文中与歧义词有句法依存关系的成分。充分发挥词典的灵活性,提高了模型训练的效率。在与其他模型的对比中,本文的模型取得了最好的效果,达到了80% 以上的准确率。这说明语言知识对词义消歧起着十分重要的作用。因此,在词义消歧任务中,不应该仅仅关注算法和模型的研究,更应该对语言知识加以关注,丰富的语言知识能够更好地促进消歧的效果。

词义消歧作为自然语言处理中的一项基础任务,它的提升能够很好地推动自然语言处理技术的发展,为机器翻译、信息检索等一系列下游任务的发展起到积极作用。不仅如此,在最近的研究中,词义消歧的思想已经影响到视觉领域。例如,SemEval-2023 任务1[18-19]是一个文本-图像匹配的任务,许多研究者利用词义消歧的思想来解决这个问题。词义消歧是一个十分重要的任务,在未来的工作中,应进一步尝试各种方法来推动其发展。