基于VGG16网络的火灾图像识别方法研究

作者: 徐柯 王保云

摘要:为了更有效地识别不同场景下的火灾信息,基于VGG16网络和残差结构设计了一种改进的VGG图像型火灾识别方法。首先,改进的网络保留了VGG16网络的特征提取层;其次,考虑到火灾识别是二分类问题,故将VGG16网络中的3层全连接层改进为2层全连接层;最后,使用残差结构以避免梯度消失问题。通过实验,结果表明:改进的VGG网络对火灾图像分类识别准确率为81.21%,AUC值为0.879,优于VGG16网络和Resnet34网络,可准确识别火灾信息。

关键词:卷积神经网络;火灾识别;深度学习;残差结构;VGG16

中图分类号:TP18 文献标识码:A文章编号:1009-3044(2023)16-0029-03

0 引言

火灾作为常见的灾害之一,对人民生命和财产构成巨大威胁。据应急管理部消防救援局2022 年11月1日发布的视频,2022年前三个季度全国共接报火灾63.68万起,死亡1441人,受伤1640人,直接财产损失55亿元。因此,对火灾的快速、高效地检测并预警显得尤为重要。传统的感烟和感温型火灾探测方法对于小空间范围适用性较好,但在大空间范围内,这种火灾识别方法具有一定的局限性。相比于传统的感烟和感温火灾识别方法,图像型火灾识别可以很好地避免这一缺点 。李建文等人[1]通过对核电站场所内火灾发生的特点进行分析,结合图像分析技术的优势,降低了核电站的火灾探测误报率;王媛彬等人[2]通过提取火灾火焰图像的特征,对是否有火焰产生实现了判断。马越豪等人[3]利用无人机技术,通过图像的颜色特征检测火灾区域,提出了一种火灾检测方法。Kandil等人[4]提取火焰小波变换后的图像特征,通过使用BP 神经网络进行火焰的识别。然而,以上这些基于图像处理的火灾识别方法均属于传统的图像处理方法,需要人工提取特征,易受干扰且效率较低。

随着深度学习[5]的发展,卷积神经网络(CNN) 已经在手写字符识别、语音识别[6]、图像识别等领域得到了成功应用。与传统的机器学习图像识别算法相比,卷积神经网络具有无须人工提取特征,局部区域连接以及权值共享特点。本文基于改进的VGG16网络模型,对图像进行发生火灾和未发生火灾的分类,借助深度学习的方法,让计算机通过大量样本训练提取到火灾特征,对火灾进行识别,并将该网络与ResNet34 网络和VGG16网络进行对比,测试网络在火灾数据集上的性能表现。

1 数据和模型

1.1 数据来源

本文采用的火灾样本数据集来自公开数据集“Fire Image Data Set for Dunnings 2018 study – PNG still image set”静态火灾图像数据集。为保证样本的平衡,选取火灾图像4 000张,非火灾图像4 000张。

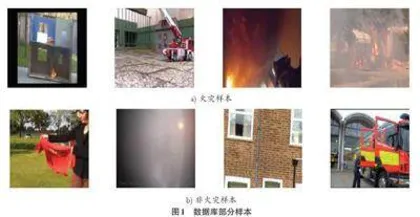

将发生火灾的图像标注为0,未发生火灾的图像标注为1,训练集和测试集按照7:3的比例进行划分,数据库中的部分图像如图1所示。

1.2 网络模型

本文分别采用VGG16、ResNet34 以及改进的VGG 网络模型对数据集进行训练和测试。其中VGG16[7]是由牛津大学和Google公司共同研发的一个卷积神经网络结构。VGG16网络是由13个卷积层和5个池化层组成,最后由3个全连接层作为分类层。

在本文中,考虑到火灾识别是一个二分类问题,不需要复杂的分类层,故保留VGG16网络中的特征提取层,重新设置分类层,采用2层全连接层 [8]。VGG16网络的特点是采用连续的3×3的卷积核代替较大卷积核,相比直接使用大尺度卷积核训练,训练量大大减小,通过增加通道数提高了网络特征识别能力,并且VGG16网络的非线性能力增强,增加了卷积神经网络特征提取能力。

残差神经网络[9](ResNet)是由何恺明等人提出的,并在ILSVRC2015比赛中取得冠军。ResNet34是由33 层卷积层和1层全连接层组成的神经网络模型。残差网络主要由残差块构成,这种残差块的输入会经过一个跳跃结构输出到残差块的输出,避免了网络退化的问题,同时缓解了在深度神经网络中增加深度带来的梯度消失问题。

改进的VGG网络模型是在原来的VGG16模型的基础上添加了残差块结构,改进的VGG 网络结构见图2。

三个网络的激活函数均使用Rule函数,选择Rule 函数是因为在一定程度上解决了梯度消失的问题,加速梯度下降的收敛速度,并且Rule函数计算简单,更加高效。

三个网络在经过对图像的特征提取和分类后,通过使用Softmax函数将两个目标类别给出的输出数值转化为相对概率。关于Softmax 函数的定义表达式为:

2 实验结果与分析

2.1 实验环境及超参数设置

模型的训练与测试均在PyTorch框架下完成。硬件 环 境 :Intel(R) Xeon(R) Platinum 8157 CPU @ 2.30GHz,NVIDIA GeForce RTX 3090 GPU;软件环境:Ubuntu18.04 操作系统, Python 3.8, CUDA 11.3,Py⁃Torch 1.11.0,以及图像相关的第三方库。

模型训练时使用GPU加速,具体训练设置如下:最大训练数设置为100个epoch,batch size设置为64,学习率设置为0.001。损失函数为交叉熵损失函数(Cross Entropy Loss) ,交叉熵函数可以完美解决均方误差函数权重更新慢的问题,在误差大时权重更新快,在误差小时,权重更新慢。交叉熵损失函数的表达式为:

优化方法为随机梯度下降法(SGD) ,该算法是通过迭代运算不断优化参数,使损失函数最小化。

2.2 训练结果

为比较3种网络的性能,在数据集上进行实验,得到实验结果,绘制了以下图像。

训练迭代100次,图3是在训练过程中,网络模型的损失值随着迭代次数变化的曲线图。观察图3的损失值曲线发现,随着迭代次数的增加,3种网络模型的损失函数均呈递减形式,并最终都稳定在一个数值;从图3还可以看出,改进后的VGG模型在损失方面要优于其他两个网络。

在测试集上的准确率如图4所示。观察图4发现,随着训练迭代次数的增加,3种模型的准确率均呈递增形式,并最终收敛;除此之外,改进后的VGG模型在准确率上明显优于其他两个网络。

2.3 性能评估

为了评价算法对火灾的识别能力,本文通过召回率、准确率、受试者操作特征曲线(ROC) 以及AUC四个指标,对网络性能进行评价。

首先,给出实验结果汇总后得到的混淆矩阵。混淆矩阵是一种精度评价模型,主要比较预测值和实际值在不同类别上的表现。表1为3种网络在测试集上的混淆矩阵。通过观察表1混淆矩阵发现,改进的VGG模型对有火发生的识别能力要优于无火灾发生的识别能力。并且改进的VGG模型对有火发生的识别能力要优于另外两个网络。

3 结束语

针对传统火灾探测器检测局限性、检测率低的问题,本文提出了一种改进的VGG网络的图像型火灾识别方法。本文选取公开数据集上的4 000张火灾照片和4 000张未发生火灾的照片,保证了样本的平衡,并将数据集按7:3分为训练集和测试集,对改进的VGG 模型进行实验,得到的火灾识别模型分类准确率为81.21%,AUC 值为0.879,网络性能优于VGG16 网络和ResNet34网络,说明了该网络可以应用于火灾识别,且具有准确的优点。

参考文献:

[1] 李建文,刘旭升,孙宝承,等.图像分析技术在核电站火灾探测中的应用[J].消防科学与技术,2019,38(10):1441-1443.

[2] 王媛彬,马宪民.基于图像特征的火灾火焰识别方法[J].消防科学与技术,2012,31(2):126-128.

[3] 马越豪,卢晓,董佩,等.基于图像特征的无人机火灾检测[J]. 消防科学与技术,2019,38(5):658-660.

[4] oKgannidtiioln M[C,]S/a/IlEamEEa MEU.AR OneCwO hNy,bSrt.iPd eatelgrosbriuthrgm,R fuors sfiiare.I EviEsEio,n2 0r0ec9⁃:

[5] S1c4h6m0-id1h4u6b6e.r J.Deep learning in neural networks:an overview[J].

[6] NHeinutroanl NGe,Dtweonrgk sL,2,Y01u5 D(6,1et) :8al5.-D1e1e7p. neural networks for acoustic smeoadrcehli nggr oiunp ss[pJ]e.eIEchE Ere Scioggnnailt ioPnro:ctheess isnhga rMeda gavzieinwes, 2o0f 1f2o,u2r9 (r6e)⁃:

[7] 8S2im-o9n7y.an K,Zisserman A.Very deep convolutional networks for laarrXgiev-:1sc4a0l9e. 15im56ag.het tprse:c//oagrnxiitvi.oonr[gE/aBb/sO/1L4].09[2.1052516-.10-20]. 2014:

[8] 蒋珍存,温晓静,董正心,等.基于深度学习的VGG16图像型火灾探测方法研究[J].消防科学与技术,2021,40(3):375-377.

[9] Hagee Kre Mco,gZnhiatinogn [XC ]Y//,2R0e1n6 S I EQE,eEt aCl.oDnefeerpe nrecsei douna Cl loemarpnuitnegr fVoris iimon⁃ a2n0d1 6P:7a7tt0e-rn7 7R8.ecognition (CVPR). Las Vegas, NV, USA. IEEE,

【通联编辑:唐一东】