基于生命周期的大数据安全分析与探究

作者: 杨小漫

摘要:大数据平台中多个技术关系复杂,数据流转链条较长,数据转换环节和处理活动较多,存在威胁暴露面大、触发源和不可控因素较多,而且大数据安全是动态发展的,数据安全措施需要不断升级和探索。从大数据生命周期视角分析每个阶段大数据存在的安全风险,梳理前沿大数据安全技术的研究现状,提出基于生命周期的大数据安全架构,确保每个节点及整个处理流程的安全措施全覆盖,为更全面地构建可控、可信、可管的大数据安全保护体系提供参考。

关键词: 大数据; 数据安全;生命周期;可信可控;安全架构; 全面防护

中图分类号:TP309.2 文献标识码:A

文章编号:1009-3044(2023)26-0087-05

开放科学(资源服务)标识码(OSID)

0 引言

习近平总书记就推动大数据和数字经济相关战略部署、发展大数据产业多次做出重要指示。2021年工业和信息化部发布了《“十四五”大数据产业发展规划》,促进大数据产业从规模增长向结构优化、质量提升转型。大数据技术正加速人类社会各个方面的深刻变革,由数据驱动的应用在各个领域发挥重要作用,数据的重要性和潜在价值日益提升。也正因大数据的潜在价值,使其面临着攻击、泄露、滥用等风险,这些安全风险还将随着大数据技术的发展全面辐射到各行各业。因此,大数据安全是发展大数据的前提,也是被重点研究的课题。

1 大数据安全

1.1 数据安全背景

近年来,全球数据安全事件持续高频发生,2018年印度政府身份数据库Aadhaar遭入侵;2020年甲骨文公司泄露数十亿条网络数据记录;2022年国内西工大邮件系统遭境外组织攻击等,这些数据安全事件造成企业资产丢失、品牌信誉塌陷等重大损失,甚至让国家安全和社会稳定面临威胁。世界各国已出台数据安全相关政策,设立各层次、各领域的法律法规,例如,欧盟实施的关于个人隐私保护的通用数据保护条例、巴基斯坦的《2020年个人数据保护法案》、美国的《美国数据隐私保护法》、俄罗斯的《个人数据保护法案》和英国的《开放数据白皮书》等。

我国“十四五”规划指出“加快推进数据安全、个人信息保护等领域基础性立法,强化数据资源全生命周期安全保护”。已实施的《网络安全法》《数据安全法》《个人信息保护法》《数据安全管理办法》等持续健全我国数据安全法律法规矩阵。各行业的数据安全标准规范也密集落地实施,腾讯构建以“科技为善、数据有度”为价值理念的数据安全管理体系;联通大数据坚持“数据安全是生命线、安全事件零容忍、敏感数据不出门”三大安全原则;阿里巴巴提出大数据安全能力成熟度模型。虽然国内各界加快推进数据外规内化、风险治理方面的步伐,但是大数据安全与隐私保护的基础性、原创性成果不足[1],且“定制化”攻击技术层出不穷,攻击形式隐蔽、多样,大数据安全将面临更多的新挑战。

1.2 大数据安全面临的挑战

大数据安全既可指大数据自身安全也可指大数据技术应用于安全,本文是对大数据自身安全进行探讨,即保障大数据的完整性、可靠性、可用性和机密性。大数据“5V”特性、开放性、动态性及分离性赋予了大数据安全区别于传统数据安全的特殊性。

挑战一:如何构建实时、高效的大数据安全保障体系。大数据平台是分布式系统部署,具有众多复杂的数据应用访问者,安全风险成因也瞬息万变。因此,大数据平台的安全措施不但要全节点、全流程覆盖,还要保证实时、高效。

挑战二:如何改善大数据安全技术的滞后性。大数据在处理方式、系统结构、应用理念等方面不断革新,迫使大数据平台安全需求和防护理念随之改变。随着批流一体、湖仓一体、HTAP(混合事务分析处理)等融合架构的研究与应用,框架自身的安全技术也需快速更新。另外,前沿大数据技术反被黑客用来实现更精准的攻击,若提升安全技术的更新速度则能在攻击与保护的博弈中赢得先机。

挑战三:如何解决大数据安全等级和高效处理之间的矛盾。安全是效率的基础,效率是安全的核心。大数据安全等级越高越会影响数据处理效率,而追求大数据处理效率也会调整安全等级。如何协调两者也是大数据安全面临的难题。

挑战四:如何权衡大数据安全和开放。大数据是在开放和流通中不断创造新价值的特殊资产,而数据频繁地跨界流动与共享将带来更严峻的安全风险。若处理好安全和开放,则能实现大数据“可用不可见”“可算不可识”。

挑战五:大数据平台的整套安全体系还不完善。目前,通过采用Hadoop生态内的一系列组件实现大数据的采集、存储和处理功能,针对单个组件或单个环节的加密技术(如HDFS、HBase等加密)较为成熟,但对组件间数据流转的安全保护较弱,整套安全体系还有待完善。

2 基于生命周期的大数据安全分析

大数据生命周期主要包括数据采集、传输、存储、处理与共享、销毁五个阶段,每个阶段都面临着数据丢失、泄露、被篡改等风险。

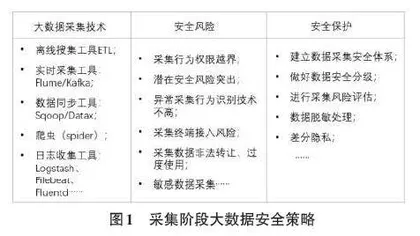

2.1 采集阶段大数据安全分析

大数据采集是指通过各种渠道汇聚复杂关联的基础源数据,是安全建设的第一道屏障。采集数据的质量决定数据的价值,采集安全又是采集质量的保障。大数据采集安全性主要表现在采集终端的接入、敏感和隐私数据采集、采集行为权限及异常采集识别等方面。

大数据采集方法有多种,依数据来源分为:数据库采集、系统日志采集和网络数据采集;依采集端分为:移动大数据采集、网上行为大数据采集、感知设备数据采集;依时效性分为离线和实时采集。目前较流行的采集技术主要有:离线采集ETL、实时采集Flume/Kafka、数据同步Sqoop/Datax、爬虫、日志收集Logstash、Filebeat等。

1) 安全风险分析

采集时及采集后都可能出现数据安全风险,特别是采集后存在脱离数据所有者控制的情况。大数据采集的数据复杂、来源广,参与方多,面临的不安全因素也较多。

①采集行为权限越界

虽然数据安全相关法律法规已落地实施,但实际应用情况复杂多变,存在越权采集、超出目的使用、非法转让等异常行为。例如,恶意爬虫不遵守robots协议、违反网站意愿强行突破反爬措施、采集法律保护的特定数据,而且爬虫与反爬虫持续博弈,爬虫技术不断升级。

②潜在安全风险突出

随着机器学习、智能算法的优化及应用,采集不敏感或非隐私数据也会隐藏着安全风险。若数据所有者对数据结构深入分析不够,缺少采集风险评估,那么采集者可通过群组特性、关联规则、聚合分析等方法,挖掘出涉密目标或形成更有价值的衍生数据。虽然可通过技术(如匿名化、去标识化等)对数据进行泛化或扰动来降低数据敏感度和被重识别的可能性,但是部分方法与背景知识密切相关,保护水平有限。

③异常采集行为识别技术有待提升

某些领域采集安全边界较模糊,异常采集行为较隐蔽,而且劣质信息源(如社交媒体上的水军,电商虚假评论等)普遍存在,导致异常采集行为的识别难度加大。

2) 数据安全保护策略

大数据采集安全的目标是在提升采集效率和质量时保障采集安全、提高非法采集行为的识别能力。

①建立数据采集安全体系

目前,大数据采集技术的安全机制普遍不完善,不但要从技术、管理、法律等方面规范采集行为,还要升级数据脱敏、数据分级、采集权限管理等方面的技术,保证采集数据遵循最小化原则[2],逐步完善采集安全体系。

②做好数据安全分级

在熟知源数据结构基础上,按需细化数据粒度、数据权属、使用期限等管理规范,依数据敏感性或影响程度进行安全分级。做好数据层隔离和权限管理,降低由数据易复制特性带来的数据滥用风险。

③进行采集风险评估

对采集设备管理、采集行为、采集环境等做好安全风险评估,使用基于数据挖掘的入侵检测系统,提升潜在异常采集的识别。

④数据脱敏

脱敏让敏感数据既不被泄露又保证数据可用性的特性。随着脱敏算法、脱敏能力及脱敏性能的进步,脱敏技术在精确识别敏感数据时,还要提升数据脱敏的智能化。基于人工智能的敏感数据自动识别、异构大数据脱敏、智能自适应脱敏算法等都是数据脱敏研究的热门方向[3-4]。

⑤差分隐私

差分隐私保护是通过加噪来抵御差分攻击[5],既可用于数据收集阶段也可用于信息分享阶段。小米公司运用差分隐私保护用户的真实数据,Google利用本地化差分隐私保护技术从浏览器每天采集千万用户行为统计数据。

2.2 传输阶段大数据安全分析

1) 安全风险分析

大数据传输的数据量大、产生速度快,容易产生传输网络拥堵、节点故障等问题,导致传输安全性、实时性和稳定性较差,影响大数据分析处理的时效性和准确性。大数据传输安全体现在内部和外部安全:内部安全指在整个传输过程中传输介质的物理安全性和网络稳定性,保证数据完整、可用;外部安全要求能防御外来非法攻击(传输信道干扰、拦截攻击等)。

2) 数据安全保护策略

已有从优化传输模型、数据加密、网络隔离等方面研究大数据安全传输的成果,如:基于同态哈希认证的大数据安全传输[6]。大数据安全传输应在优化响应时间、吞吐量等传输性能指标的同时升级安全传输策略。

①身份识别

传输层对接的客户端比较多,传输数据之前一定要做好身份识别。

②优化传输策略

针对已安全分级的数据,依级别采取不同的优先安全传输策略,达到既缓解传输压力又保障安全传输的目的。

③量子通信

量子有量子态不可克隆、不确定性、量子态测量坍塌的特点,通过量子密钥分发、量子密钥中继、经典量子波分复用等技术实现量子加密传输,保障传输的绝对安全。所以,量子通信的保密性强、鲁棒性高、速率快、容量大、远距离传输等优点助力大数据实现安全传输。

④边缘计算

它是将计算、存储、网络和应用服务功能分散到靠近数据源的边缘设备上,以便本地处理和分析数据,提供最近端服务。核心是为了产生更快的网络服务响应,满足实时业务、安全与隐私保护等方面的需求。利用边缘计算可一定程度上缓解大数据的传输负荷,提高大数据传输可靠性和安全性。

2.3 存储阶段大数据安全分析

1) 安全风险分析

大数据存储的核心任务是存储和管理数据,保障数据不丢失、不泄露、不被篡改以及服务不中断,处于大数据生命周期中的核心位置。存储安全是大数据安全的重中之重。

①存储方式的安全机制不完善

大数据存储方式主要有分布式系统、NoSQL数据库和云存储。NoSQL主要以提高海量数据的处理速度和扩展性为主,而内部安全机制尚不完善,诸如授权过程、身份验证和输入验证等 [7]。云存储中因用户数据管理权和所有权分离,数据安全和隐私保护是云存储的难题。

②存储性能与安全间的矛盾

大数据存储系统不但要考虑数据的安全可靠、系统的备份和还原能力,还要优化检索效率、搜索响应时间等性能指标。加密技术可保障大数据存储数据安全,但也会带来计算负担,造成响应延迟。

③新存储架构中安全策略更新滞后

数据湖、湖仓一体等新型架构的研究为解决“数据孤岛”问题提供了新思路,但因处于发展阶段,其数据安全策略更新略显滞后。若能对数据湖进行访问控制优化,控制力度做到“库表列行”等不同级别,则可避免数据湖退化为“数据沼泽”。

④大数据加密算法的优化

大数据对加密算法要求较高,既要到达安全目标又要保持低耗能和存储效率。若在大数据分布式存储系统中加密信息和相关各类参数不同步更新,将导致数据形态的不对等,影响计算的准确性。