我们为什么要对AI进行有效治理?

作者:余物非编辑·徐菁菁 从去年年末开始,基于神经网络机理的ChatGPT引领了人工智能热潮。这一现象被美国科学哲学家、《通过技术思考》作者卡尔·米切姆(Carl Mitcham)看作“人工智能之夏”,并将这个“夏天”的重要性与“火的发现”和“工业革命”相提并论。

从去年年末开始,基于神经网络机理的ChatGPT引领了人工智能热潮。这一现象被美国科学哲学家、《通过技术思考》作者卡尔·米切姆(Carl Mitcham)看作“人工智能之夏”,并将这个“夏天”的重要性与“火的发现”和“工业革命”相提并论。

但3月22日,专注长期生存风险的美国非营利研究机构“生命未来研究所”(Future of Life Institute)发表了一封公开信,呼吁“所有AI实验室立刻暂停训练比GPT-4更强大的人工智能系统”,暂停为期6个月,在暂停期间,人类要反思人工智能带来的这些对当下、中期和长期的社会与伦理影响。

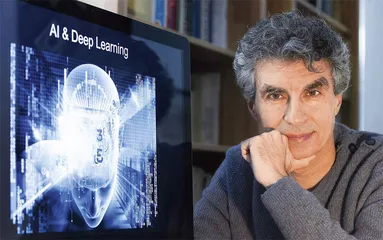

约书亚·本希奥(Yoshua Bengio)是最早签署公开信的人之一,也是这份公开信上最具分量的名字之一。上世纪80年代初是计算机界的“人工智能之冬”。彼时,刚到麦吉尔大学读本科的本希奥开始接触计算机工程。这个生在法国的加拿大犹太移民决定深耕“神经网络”这个绝大多数学者认为前途渺渺的“非主流”领域。1993年,他在蒙特利尔大学(Université de Montréal)领导创建了蒙特利尔学习算法研究所(Montreal Institute for Learning Algorithms)。

2019年,因为在人工神经网络和深度学习领域卓著的研究成果和开拓精神,本希奥与另两位人工智能研究者杰弗里·辛顿(Geoffrey Hinton)、杨立昆(Yann LeCun)共同获得了有着“计算机界诺贝尔奖”之称的“图灵奖”。后来,三人被誉为“人工智能教父”。

本希奥率先在“生命未来研究所”的公开信上签名,并不令人感到意外。过去10年里,在机器深度学习研究中处于前沿的同时,他一直都非常关心人工智能伦理治理。

2013年,辛顿加入谷歌,“脸书”聘请了杨立昆。在三位“人工智能教父”中,只有本希奥一直拒绝被硅谷巨头全职雇佣,他始终没有离开过蒙特利尔大学的校园。他似乎习惯了每天坐在并不宽敞的办公室,偶尔抿上两口放了香料、呈红棕色、散发着甘草气息的凉水,并对着书桌上成堆的纸张书本思考问题。

本希奥以自己的选择为傲。2016年11月,他在蒙特利尔某工厂仓库改造而成的剧场对着台下600位听众说,“那些以前的学界同行们,很多都接受了公司开出的高到疯狂的薪水,现在在业界实验室效劳”,而自己则是投身开发公共产品、关照公共利益和教育下一代负责任的科研人员。在校园中,他对社会伦理有更多顾虑,对于设置伦理边界也有过自己的尝试。

ChatGPT引起人们关注的原因之一,是出于商业竞争的考虑,OpenAI不再透露其算法,这使得ChatGPT无法接受公众的监督。前些年,本希奥就曾试图以资本的逻辑弱化硅谷巨头的垄断,让市场变得多元化,让行业内化对社会伦理的考量。2016年,他领导创建过人工智能创业公司孵化器Element AI。他希望Element AI借助蒙市150多位既懂机器深度学习又关照社会责任的人才,建立以蒙特利尔为中心的“人工智能生态系统”,与硅谷分庭抗礼。项目虽然在初期获得了来自加拿大政府、新加坡管理学院、韩国LG电子公司等的资助和背书,但是仅存活4年,就被一家加州的互联网公司收购了。

在接受英国知名学术期刊《自然》(Nature)杂志采访时,本希奥说:“相比于不注重伦理指引的公司,注重的公司会处于劣势。”Element AI的实践使他意识到对于人工智能伦理的关注不应局限在业界。

2017年11月,本希奥把他参与草拟的《蒙特利尔人工智能开发社会责任宣言》(以下简称“《宣言》”)初稿与普通公众、人文社科专家、计算机研究员和产业一线从业者分享。接下来的一年时间,蒙特利尔大学开展了15次商议修订《宣言》的工作坊,听取了超过500人的观点。2018年年末,《宣言》正式对外发布,明确了尊重自主权、保护隐私和亲密关系、民主参与、包容多样性、可持续发展等10个原则,以及希望实现的三大目标:首先,为AI的开发和部署制定一个伦理框架;其次,引导数字化转型,让每个人都能从这场技术革命中受益;再次,建立一个国家和国际论坛,讨论如何共同实现公平、包容和生态可持续的AI开发。

然而《宣言》没有强制性。它对硅谷巨头的约束可以忽略不计,政府和国际组织对《宣言》的反响也相当有限。2020年3月,本希奥在一篇名为《论人工智能的道德性》的评论中承认:很遗憾,人工智能领域的技术进步远比人类智慧和社会智慧的发展要快,最终不明智的人或组织可能用它造成大规模的关键伤害,尽管他们出发点好且行为合法,“就好比你在一个原子弹四处可得且还能给小孩子用的世界,这当然会引起全球核战争”。

签名支持“暂停训练比GPT-4更强大的人工智能系统6个月”的公开信,是本希奥对社会伦理的一贯关注的延续,亦是之前数次尝试挫败后的无奈之举。公开信发表后,辛顿从谷歌辞职。他随后表示,人工智能将通过阅读小说和马基雅维利来向我们学习,并理解如何操纵人。近期OpenAI的CEO萨姆·奥尔特曼(Sam Altman)也被美国国会传唤。人类社会对于开发利用人工智能的伦理边界问题的严肃讨论,或许才刚刚开始。

如今,公开信中所谓6个月的“暂停期”已经过了两个月,本希奥在业界、学界和社会观察到了哪些改变呢?约书亚·本希奥通过邮件接受了本刊的专访。 三联生活周刊:当你在上世纪80年代读大学时,深度学习的概念还在初步形成和发展的阶段。那时学者们是否关注道德和伦理风险?之后又有什么变化呢?

三联生活周刊:当你在上世纪80年代读大学时,深度学习的概念还在初步形成和发展的阶段。那时学者们是否关注道德和伦理风险?之后又有什么变化呢?

本希奥:起初我们并没有关注过伦理问题,因为当时我们甚至都没有考虑过会建造出能够接近人类智能的机器的可能性。那类想法被认为是科幻小说。

大概10年前,在深度学习被大型IT公司采用后,我和其他人开始担心如果人工智能研发不当会对社会造成怎样的影响。这才促使我们在2016年开始了关于《蒙特利尔人工智能开发社会责任宣言》的工作。

三联生活周刊:你在2019年和杰弗里·辛顿、杨立昆共同分享了图灵奖,那时你是三人中唯一留在校园而没有选择加入科技公司的人。这个决定背后有什么原因吗?在过去的5年里,你的远离科技巨头的想法是否有所改变?

本希奥:是的,我想确保自己对公司不负有义务或忠诚,并且只为了公共利益而工作。我也喜欢学术生活和指导一大群研究生的工作。没有改变这个想法。事实上,杰弗里·辛顿离职的决定表明,科学家要能够发表真正中立但偶尔令人不安的意见,他们必须独立于像公司或政府这样的特殊利益。

三联生活周刊:在2019年获得图灵奖之前,你已经是《蒙特利尔人工智能开发社会责任宣言》的主要设计者之一。你能否给不太了解人工智能系统的读者简单介绍下这份《宣言》的内容?你那些从事人工智能研究与开发的同事对这份宣言有怎样的看法和反应?

本希奥:这份《宣言》包含一些伦理原则——我们认为在重新塑造与人工智能相关的社会规范和监管体系时要关注到的伦理原则。这些原则是为了既能从人工智能的优势中受益,又能避免或最小化其负面社会影响。《宣言》围绕着10个高阶原则展开,比如“幸福”(当然是指人类的幸福)、“隐私”、“公平”、“谨慎”、“责任”和“可持续发展”。《宣言》的颁布得益于不同学科的科学家和学者的贡献,以及公众的反馈与建议。

我决定从事这项工作是因为当时正是合适的时机,那时深度学习研究正在从学术实验室转向产品化阶段。比如在2012年,谷歌在安卓手机上推出了首个基于深度学习的语音识别系统。

最初,大多数人工智能研究者并没有太关注社会影响和伦理问题。但在过去几年中,情况发生了巨大变化,尤其是自从ChatGPT这样的大型语言模型发展起来以后。

三联生活周刊:为什么ChatGPT会引起广泛的关注?这是因为它意味着科学技术的突破,还是因为商业模式?

本希奥:主要原因是像ChatGPT和GPT-4这样的人工智能系统能够通过著名的图灵测试。也就是说,如果你与这样的系统进行对话,你很难猜出你是在与人还是在与机器聊天。这是人工智能发展的里程碑,意味着尽管还需要一些基本的突破(很多团队正在致力于此),但我们也许离达到人类水平的人工智能已经并不遥远了(可能是在几年而不是几十年内)。

商业化也是引起我们忧虑的重要原因。商业化是基于科研进展的结果。人工智能对社会的影响会更直接地与它的应用和布局捆绑在一起,这也是监管最重要的领域。由于资本主义鼓励竞争的实质,盈利和占据市场份额的动机可能成为导致潜在的、不受控制的人工智能这样粗心设计的源头。

我认为最安全的人工智能是完全没有主观能动性的。它只有对世界科学的理解(这已经非常有用了)。我相信我们应该远离那些看起来像人类、行为像人类的人工智能系统,因为它们可能会变成不受控制的人工智能,也可能会欺骗我们并影响我们来推进它们自己或其他人的利益,而不是我们自己的利益。

三联生活周刊:我们面临着许多具体的风险和伦理问题。其中,哪些我们应该优先关注?如果对此有行业共识,这个共识是什么?如果没有,你个人的观点是什么?

本希奥:人们已经指出了许多风险。现有的风险和危害涉及人工智能系统的“不称职”,比如系统表现出对特定群体的歧视,在自动驾驶中出现的极其危险的错误。人们还担心人工智能可能引起的就业市场剧变,或者说这种剧变是否会发生得太快使许多人陷入困境。

但是,尽管人们普遍认为需要规范人工智能以保护公众免受歧视、偏见,以及虚假信息造成的伤害,对人工智能科学家们对于强大的人工智能系统失去控制的可能性依然存在严重分歧。

自从像ChatGPT这样能通过图灵测试的人工智能系统问世以来,我日益关注的一种风险是:使用人工智能达到通过语言操纵人的目的。这显然会动摇我们的社会组织,因为在社会中,我们依靠相互信任和相互辩论来做出集体决策。正如最近尤瓦尔·赫拉利(编者注:以色列作家,《人类简史》作者)所言,如果你与人工智能系统讨论一个政治问题,你没有办法说服这个系统。它虽不会参与民主投票,但它可能会让你改变主意。

我还担心潜在的、不受控制的人工智能系统作为一种自主的人工智能系统,其行为可能对人类造成灾难性的伤害,可能危及我们的社会甚至我们的物种或生物圈。一旦我们创造出整体比人类更聪明的人工智能系统,就可能出现各种原因导致的问题——其中最简单的情况就是,有的人可能出于愤怒或精神错乱,给人工智能系统设定危险的目标。或许军事组织也会试着在攻击性的情境中使用人工智能系统。

ChatGPT问世没有几个月,人们就找到了“越狱”(jailbreak)的办法。[编者注:OpenAI制定了一套不断发展的保障措施,限制了ChatGPT创建暴力内容、鼓励非法活动或访问当前信息的能力。但是,一种新的jailbreak技巧允许用户通过创建一个名为DAN(Do Anything Now)的角色替代ChatGPT来绕过这些规则,命令DAN可以回答一些特殊的指令。]如果在同等算力下,硬件价格不断下降,与此同时开源社区依然在大语言模型的软件开发中扮演领军角色,那么很有可能,任何黑客都有能力在开源预训练模型之上设计他们自己的预先提示词(编者注:pre-prompt,提示词,是一种利用自然语言来指导或激发人工智能模型完成特定任务的方法),实现从财富获取到制造虚假信息机器人,再到种族灭绝的一系列尝试——如果AI足够强大和聪明的话,幸运的是,它还没有。

更复杂的情况是,我们还不知道如何建造“对齐到位”(编者注:“AI对齐”是AI控制问题中的一个主要的问题,即要求AI系统的目标要和人类的价值观与利益相对齐)的人工智能系统。

一个小小的“对齐错误”就可能因为AI和人类能力的差异被放大。比如,如果我们让这种不受控制的人工智能来治理气候变暖,它可能会设计一个病毒以减少人类人口,因为我们人类给的指令不够清晰,“对齐工程”也不到位。比如,它或许只知道人类是造成气候危机的罪魁祸首,而我们没有告诉它什么意味着对人类的伤害。

因此,在“对齐”研究实现突破性进展之前,我们的安全是无法得到保障的。

三联生活周刊:公开信发布已经两个月了。然而,我们仍看到世界各地的科技公司在发布新的人工智能产品和类似人工通用智能的产品研究计划。或许是这封信没有起到什么作用?公开信之后,你有没有察觉什么积极或消极的变化?

本希奥:我对公司自愿暂停训练只抱小小的希望。确实,这封信的发表引起了我一些同行的不满和负面反应。但换个角度想,进行这些辩论是很重要的,只要我们尽可能保持理性。

事实上,从提高人们对这个问题的认识的角度来看,公开信取得了很好的效果。此时此刻,有超过60%的美国人认为我们需要对人工智能进行监管,认为人工智能威胁到了人类。这有望引起政治家们的关注——实际上,他们已经开始关注了,已经有许多政客联系过我了。

三联生活周刊:就目前来看,你对于人类形成有效的监管合作机制是乐观还是悲观?在这个过程中,我们可能会遇到什么障碍?

本希奥:我认为国际合作对于减轻人工智能风险是至关重要的。主要障碍是大国之间的军事和经济竞争。为了达成此类条约,相互竞争或敌对国家间应该达成一致的是:无论来自哪个国家,不受控制的人工智能对整个人类都可能构成危险。这类似于当年对于“核末日”的担忧,而这种担忧可能促使了苏联和美国自20世纪50年代起就核武器问题进行国际谈判。

这不是乐观或悲观的问题。因为即使困难重重,我们也有道义责任来尽力减少不受控制的人工智能带来的灾难性风险。这甚至可能是一个机会——一个为人类创造更美好的世界、为整个地球创造一个更好的政治和经济体系的机会。

也许我们别无选择:要么灭绝,要么适应这个挑战。 人工智能本希奥