人工智能教育应用场景下的教师伦理价值研究

作者: 沈苑 汪琼

[摘要]随着技术的发展,国内外借助人工智能支持教学和校园管理的做法日渐普遍,也相应地引发了诸多伦理讨论。以教师的伦理价值为切入点,提出思想实验方法可作为探究人工智能应用于教育的伦理困境的创新手段,选取了人工智能教育应用场景下典型的伦理价值冲突,对应开发了4个基于虚构场景的思想实验,通过问卷调查探究了教师的伦理价值取向,为可信赖的人工智能教育应用的发展提供了可参考的建议。结果表明,在角色期望方面,教师普遍希望人工智能作为教学辅助而并非直接代替他们完成教学任务;在价值排序方面,教师最担心人工智能教育应用会引发隐私方面的风险;在价值决策方面,教师倾向于强调自主以化解准确和透明的冲突、愿意让渡部分隐私换取教育福祉,以及在自主和公平内部的平衡点上存在分歧。

[关键词]人工智能教育应用;伦理价值;思想实验;价值冲突;助教机器人

[中图分类号]G434[文献标识码]A[文章编号]1005-4634(2023)03-0044-09近年来,随着人工智能(Artificial Intelligence,AI)的发展,国内外借助AI支持教学和校园管理的做法日渐普遍,也引发了诸多伦理讨论。回溯萌芽于20世纪中期的计算机辅助教学,一路上也经历了大量的伦理讨论:隐私泄露、知识产权纠纷、网络霸凌、网络成瘾等[1-2],即便是21世纪的今天,这些讨论仍旧存在于人工智能教育应用(AI in Education,AIED)的场景下。而且与一般的教育技术不同,AIED更聚焦于通过自我学习能力以实现原本人类才能完成的任务[3],这种能力所带来的不可预测性意味着其必将成为伦理问题的多发地。如果AIED在设计或使用上忽视了教育场景下利益相关者的伦理价值诉求,非但可能无法达成预期效果,反而会致使教育异化——如“拍照搜题”“AI代写”“风险学生标记”等应用都饱受社会争议[4]。从技术发展的历史规律来看,一项新技术在兴起时所受到的炒作吹捧常会暂时遮蔽其伦理和社会含义,从长期来看因伦理问题引发的后坐力可能会减慢甚至停止技术研发进程,因此前瞻性地研判和规避AIED应用场景下的伦理困境具有重要的现实意义[5]。为防范潜在风险,多国政府都发布了相关白皮书和政策文件,对AI的开发和应用制定限度规范[6]。然而,单凭去情境化的抽象原则这种外在约束依赖行动主体的自我规制最多也只能达到 “弱约束”的效果,对于实践的指导具有明显的局限性,利益相关者依旧会在技术应用场景下面临难以抉择的价值冲突[7]。

基于此,本研究以教师的伦理价值为切入点,提出思想实验作为探究人工智能应用于教育的伦理困境的创新手段,以人形助教机器人作为技术研究对象,采用实证手段重点探究了教师的伦理价值取向,包括3项研究问题:在AIED应用场景下,(1)教师希望AIED承担的角色是什么?(2)教师心中的伦理价值优先级是什么?(3)教师在面临伦理价值冲突时会做出什么样的价值决策?通过探究这些问题,旨在为AIED的研究者和设计者开展实证研究提供可参考的研究工具与操作范式,也为AIED相关政策和规范的制定提供依据与建议。

1切入视角:AIED应用场景下教师的伦理价值本研究以教师的伦理价值作为切入视角。教师作为AIED最直接的利益相关者,其主张的价值排序和决策极大地影响到技术应该如何设计、部署和使用才能符合具体教学场景下的伦理要求。

芭提雅·弗里德曼(Batya Friedman)在其著作《人类价值与计算机技术设计》(Human Values and the Design of Computer Technology)中定义价值(value)是“聚焦于伦理范畴上人类认为重要的事物”[8]。哲学家们常说的“伦理困境(ethical dilemma)” 是指人在实践中面临几种不同的、相互矛盾的伦理价值,一时难以作出判断或抉择的情境[9]。AIED在发展过程中涉及到大量的利益相关者(如开发团队、教师、校长、学生、家长等),正因为这些群体之间或群体内部持有不同的伦理价值或对价值持有不同的优先排序导致了伦理困境的产生。

AIED应用场景下的教师伦理价值一方面涉及AI技术本身自带的伦理属性,另一方面也涉及教师角色本身的伦理特性。前者已有大量的政策文本和研究报告作出论述,通过对5篇AI伦理领域内权威专家的综述文章进行主题编码分析发现,目前此领域的话语显著收敛于“透明”“公平”“自主”“安全”“隐私”“责任”“福祉”这7个主题下[10-14]。而关于教师角色本身的伦理特性方面也得到大量研究者的论证,“教学本身包含了道德行动……教师是道德主体,课堂互动在本质上不可避免地具有道德属性。”[15]有研究者分析了由189位教师提供的伦理观点,对于其中产生的223项价值冲突进行聚类,提出5类在具体教学场景下可能产生冲突的伦理规范,即“伦理人际规范”“内部专业规范”“机构规范”“社会一致性规范”“自我保护规范”[16]。

上述伦理价值在AIED应用场景下会如何表征,又是否存在潜在的价值冲突和调适路径?本研究着重选取了4项典型的价值冲突,分别是准确与透明的冲突、福祉与隐私的冲突、自主与支持的冲突、平等与包容的冲突,采用思想实验方法深入探究教师的伦理价值取向,旨在对AIED的合伦理设计和应用提供现实关照,支持可信赖AIED生态系统的未来发展。

2研究工具:基于虚构场景的思想实验

本研究将虚构场景的思想实验作为主要研究工具,探测教师在AIED应用场景下的伦理价值取向,包括教师对于AIED的角色期望、对于伦理价值的优先排序以及在面临价值冲突时的价值决策。

2.1思想实验的特征与形式

思想实验是一种按照实验的格式展开的在人的头脑中进行的理性思维活动,研究者通过向自己或被试提出一系列“What if”问题来讨论假设情境下的事物发展和结果,以寻找某个问题的答案[17]。比如:如果不存在摩擦,将会发生什么现象?如果一个人分裂为变形虫,将会发生什么现象?思想实验最早是在恩斯特·马赫(Ernst Mach)的《认识与谬误》中作为一种正规的学术研究方法提出的[18]。自然科学领域的“自由落体”“薛定谔的猫”“麦克斯韦妖”“时钟佯谬”,经济学领域的“囚徒困境”,哲学认识论领域的“特修斯之船”“空地上的奶牛”“缸中之脑”“孪生地球”等都属于思想实验。在AI领域最典型的思想实验是麻省理工大学媒体实验室开发的“道德机器(Moral Machine)”大规模在线实验,通过“严肃游戏”的方式来探索自动驾驶汽车面临的道德困境。

思想实验一般是由虚构场景(vignette)的方式来呈现的。虚构场景是指用书面或口语形式描述特定情况,模拟真实事件或问题,通过邀请回应、鼓励讨论和探测理解来获取信息,以深入了解参与者对研究核心的特定现象的信念、情感、判断、态度和价值[19-20]。如肯尼斯·斯特赖克(Kenneth Strike)和乔纳斯·索尔蒂斯(Jones Soltis)在其经典著作《教学伦理》中,通过一系列虚构案例来阐明教师在伦理困境下可能经历的思考过程和背后起作用的伦理系统[21]。书中的虚构案例包含大段场景和细节的描述,其中的道德困境十分具体和棘手,可谓是“各种伦理原则互相矛盾抵触的世纪难题”。他们把这些案例设计得如此棘手,是有意地让这些道德争议夹杂不清,这种模糊性有助于增加思考的趣味性并且使其成为有效的教育工具。虚拟案例的难解并不证明教学中的伦理问题是无解的,也不证明思考伦理议题是无意义的。在参与者对于这些复杂案例进行充分思考后,如果在现实生活中遇到较为简单的困境,就有能力更迅速地做出伦理上恰当的选择。

较之于真实实验,思想实验最大的特点在于条件理想化,可以借助虚构场景避开实际的技术困难来开展前瞻性的分析与预测,降低教育情境下的试错风险[22]。虽然思想实验是基于虚构情境,但被试的作答依旧是以事实经验和普遍规律为来源的,因此所收集到的实验数据和研究结论是具备一定可靠性和推广性的[23]。“思想实验是在想象中操作模型时形成的”[24],并非脱离实际的主观臆想。换言之,思想实验的条件是不同于事实的,但之所以能够进行思想实验,是因为推理“或多或少准确地、非任意地反映了事实”[18]。

伦理学研究常借助思想实验来突出某种“伦理困境”,大多是研究者的自问自答,是为了提出某种观点而有意设计出的困境表达,可能最后指向几种理论的矛盾争论之中,陷入非此即彼的理论抉择[25]。为规避这种局限性,本研究并不将思想实验作为一种分析工具,而是以开放的观点将思想实验作为一种收集教师观点的工具,通过为教师提供4个虚构的价值冲突场景,以探测教师在AIED应用场景下的价值取向。

2.2思想实验的伦理学基础

在本研究中运用思想实验方法是以描述伦理学为基础的。经典的伦理学论文经常论述的是一个具有“健全”观点的人的想法,即采用规范伦理学视角审视某项价值决策。然而在实际情况中,不同群体和个体对于一件事情自己会怎么做有着不同的想法和观点。描述伦理学是“对道德规范和相伴随的一个人或一群人的道德观念所作的调查,该理论认为,对道德观点的描述是人们在特定时间和特定的共同体内所持的道德原则”[26],其目的在于如实地呈现人们现实或历史的、内在或外在的道德状况,其研究对象不是社会的道德价值和行为规范,而是社会的道德事实及其规律,其任务在于记录与再现社会道德实际和揭示社会道德发展的科学规律[27]。

如果说规范伦理学关注的是“人们应该如何行动?”那么描述伦理学则更关注“人们觉得怎么做是正确的?”描述伦理学能够帮助诊断出社会的偏见,预测某个新的社会干预可能会带来的公众反应。比如“电车难题”就经常被用于描述伦理学研究中来提取公众的道德决策。有研究发现,虽然大多数人愿意拉下杠杆来救5个人,但大多数不愿意将胖子推下铁轨来救下5个人,这种取向差异有助于更加细微地探究人们内心衡量伦理价值的标准[28]。基于描述伦理学的立场,开放程度较高的思想实验有助于揭示教师内心的价值排序与态度观点,站在用户的立场上寻求更加可靠的规范AIED设计与使用的方式。

3实验设计:助教机器人的应用场景

3.1助教机器人作为技术主体

目前AIED有着多种运作方式(如软件/硬件)和多种用途(如辅助学习/教学/管理),而且收集的数据类型、规模、有效性、渗入师生生活的程度都有所不同。在本次思想实验中,研究者选择以一个能够预测学情和辅助学习的人形助教机器人“小波”作为技术研究对象,因为这类产品很大程度上代表了一种未来AI与教育深度融合的重要形式。

目前,国内外各教育阶段都开始尝试使用助教机器人辅助教学,如国内用于学前教育的Keeko、德国用于高校教学的Yuki、美国用于STEM教育的NAO等。即便国内的学校目前还没有这类助教机器人,也有学校已经开始借助AI软件来预测学情和辅助学习。虚构这样的人形助教机器人符合未来教育技术的发展趋势,研究过程和结果也能一定程度上推广到其他具有类似功能的AIED的设计和使用上。此外,选择人形机器人的原因是因为已有调查发现,虽然学生更喜欢动物形态的机器人,但是他们心目中最适合作为助教的机器人是人形的[29]。

3.2虚构场景的价值冲突设计

使用思想实验方法最关键的是要虚构出高质量的伦理困境,本研究虚构了4个有助教机器人参与的教学场景,确保场景简洁、易懂、不完整和开放[19]。

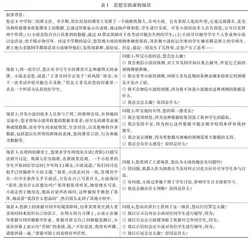

AIED应用场景中有诸多潜在的价值冲突,本研究的4个场景分别对应了4项较为典型的价值冲突(见表1)。第1个场景关注的是准确与透明的冲突,重点探究当助教机器人给出一个不透明但准确的预测时教师会如何行动;第2个场景关注的是福祉与隐私的冲突,重点探究当助教机器人通过收集隐私数据能做出更准确的预测时教师是否愿意为了效果而牺牲隐私;第3个场景关注的是自主与干预的冲突,重点探究的是当助教机器人对课堂上的学生讨论进行干预时教师是否认为这种干预损害了学生自主学习;第4个场景关注的是平等与包容的冲突,重点探究的是当助教机器人对特需学生“一视同仁”时是否会引发包容性上的争议。参与调查的教师需要分别针对4个场景给出自己的选择并阐明原因。本研究将“小波”预设为一个自动化程度较高且质量较好的机器人,其预测的准确度高且受到学生喜爱,以此来增强伦理价值冲突的复杂程度。

此外,由于每个场景都需要教师花费时间和精力去理解和思考,因此本研究将4个场景都置于某所学校的初二某班期中考试之后的一周内陆续发生,要求被试扮演班主任角色来选择自己在这个情境下会作出的判断和行动,以保持场景的连贯性,教师不需要在每读一个新的场景时就去转变自己的视角和角色,从而一定程度上规避故事背景、角色转变等因素对伦理价值取向产生的未知影响。具体见表1。